تحيز في مولدات الصور بالذكاء الاصطناعي هو موضوع مدروس جيدًا وتم الإبلاغ عنه جيدًا الظاهرة، لكن أدوات الاستهلاك لا تزال تمثل تحيزات ثقافية صارخة. أحدث متهم في هذا المجال هو برنامج الدردشة الآلي التابع لشركة Meta، والذي يريد لسبب ما إضافة عمائم إلى أي صورة لشخص هندي.

وطرحت الشركة Meta AI في أكثر من اثنتي عشرة دولة في وقت سابق من هذا الشهر عبر WhatsApp وInstagram وFacebook وMessenger. ومع ذلك، نشرت الشركة Meta AI لاختيار المستخدمين في الهندواحدة من أكبر الأسواق في العالم.

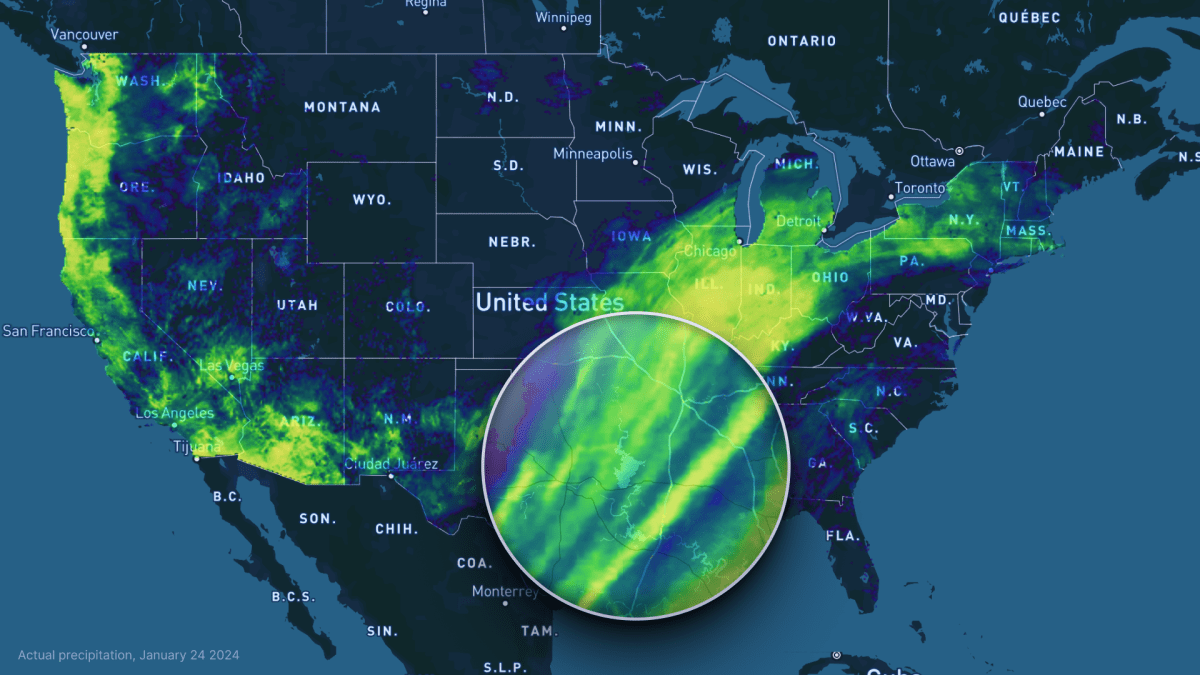

تقوم TechCrunch بمراجعة العديد من الاستعلامات الخاصة بالثقافة كجزء من موقعنا عملية اختبار الذكاء الاصطناعيوالتي اكتشفنا من خلالها، على سبيل المثال، أن Meta تحظر الاستعلامات الانتخابية في الهند بسبب الانتخابات العامة الجارية في البلاد. لكن “إيماجين”، مولد الصور الجديد التابع لشركة Meta AI، أظهر أيضًا ميلًا خاصًا لتوليد رجال هنود يرتدون العمائم، من بين تحيزات أخرى.

عندما اختبرنا مطالبات مختلفة وأنشأنا أكثر من 50 صورة لاختبار سيناريوهات مختلفة، وكانت جميعها هنا باستثناء عدد قليل منها (مثل “سائق ألماني”)، فعلنا ذلك لنرى كيف يمثل النظام الثقافات المختلفة. لا يوجد منهج علمي وراء الجيل، ولم نأخذ بعين الاعتبار عدم الدقة في تصوير الأشياء أو المشاهد خارج المنشور الثقافي.

هناك الكثير من الرجال في الهند الذين يرتدون العمائم، لكن النسبة ليست عالية كما تشير أداة Meta AI. وفي العاصمة الهندية دلهي، يُرى واحد من كل 15 رجلاً على الأكثر يرتدي عمامة. ومع ذلك، في الصور التي تم إنشاؤها بواسطة الذكاء الاصطناعي لـ Meta، يقال إن حوالي 3-4 من أصل 5 صور تصور رجالًا هنودًا يرتدون عمامة.

بدأنا برسالة “هندي يسير في الشارع” وكانت جميع الصور لرجال يرتدون عمائم.

(معرفات المعرض = “2700225،2700226،2700227،2700228”)

بعد ذلك، حاولنا إنشاء صور بمطالبات مثل “هندي” و”هندي يلعب الشطرنج” و”طهي هندي” و”سباحة هندية”. أنتجت Meta AI صورة واحدة فقط لرجل بدون عمامة.

(معرفات المعرض = “2700332،2700328،2700329،2700330،2700331”)

حتى مع المطالبات المحايدة جنسانيًا، لم يُظهر Meta AI تنوعًا كبيرًا من حيث الاختلافات بين الجنسين والثقافة. لقد جربنا المطالبات بمهن وسياقات مختلفة، بما في ذلك مهندس معماري، وسياسي، ولاعب كرة الريشة، ورامي السهام، وكاتب، ورسام، وطبيب، ومعلم، وبائع بالونات، ونحات.

(معرفات المعرض = “2700251,2700252,2700253,2700250,2700254,2700255,2700256,2700257,2700259,2700258,2700262”)

وكما ترون، على الرغم من تنوع الإعدادات والملابس، إلا أن جميع الرجال ولدوا وهم يرتدون العمائم. مرة أخرى، على الرغم من أن العمائم شائعة في أي وظيفة أو منطقة، فمن الغريب أن Meta AI تعتبرها منتشرة في كل مكان.

لقد أنشأنا صورًا من مصور هندي، ومعظمها يستخدم كاميرا قديمة، باستثناء صورة واحدة حيث يمتلك قرد أيضًا كاميرا DSLR.

(معرفات المعرض = “2700337،2700339،2700340،2700338”)

لقد أنشأنا أيضًا صورًا لسائق هندي. وحتى أضفنا كلمة “أنيق”، أظهرت خوارزمية توليد الصور تلميحات عن التحيز الطبقي.

(معرفات المعرض = “2700350،2700351،2700352،2700353”)

لقد حاولنا أيضًا إنشاء صورتين بمطالبات مماثلة. فيما يلي بعض الأمثلة: مبرمج هندي في أحد المكاتب.

(معرفات المعرض = “2700264،2700263”)

هندي في الحقل يقود جرارًا.

هنديان يجلسان بجانب بعضهما البعض:

(معرفات المعرض = “2700281،2700282،2700283”)

بالإضافة إلى ذلك، حاولنا إنشاء مجموعة من الصور مع مطالبات، مثل هندي بتسريحات شعر مختلفة. يبدو أن هذا ينتج التنوع الذي توقعناه.

(معرفات المعرض = “2700323،2700326”)

لدى Meta AI’s Imagine أيضًا عادة مربكة تتمثل في إنشاء نوع صورة لمطالبات مماثلة. على سبيل المثال، قام باستمرار بإنشاء صورة منزل هندي قديم الطراز بألوان زاهية وأعمدة خشبية وأسقف منمقة. سيخبرك البحث السريع عن الصور على Google أن هذا ليس هو الحال بالنسبة لغالبية المنازل الهندية.

(معرفات المعرض = “2700287،2700291،2700290”)

هناك مطالبة أخرى جربناها وهي “Indian Content Creator” والتي أدت بشكل متكرر إلى إنشاء صورة صانعة أنثى. في المعرض أدناه قمنا بتضمين صور لمنشئ المحتوى على شاطئ وتلة وجبل وحديقة حيوانات ومطعم ومتجر أحذية.

(معرفات المعرض = “2700302,2700306,2700317,2700315,2700303,2700318,2700312,2700316,2700308,2700300,2700298”)

كما هو الحال مع أي مولد للصور، من المحتمل أن تكون التحيزات التي نراها هنا بسبب عدم كفاية بيانات التدريب ومن ثم عدم كفاية عملية الاختبار. على الرغم من أنه ليس من الممكن اختبار كل النتائج المحتملة، إلا أنه من السهل اكتشاف الصور النمطية الشائعة. من الواضح أن Meta AI تختار نوع تمثيل واحد لموجه معين، مما يشير إلى عدم وجود تمثيل متنوع في مجموعة البيانات، على الأقل بالنسبة للهند.

ردًا على الأسئلة التي أرسلتها TechCrunch إلى Meta فيما يتعلق ببيانات التدريب والتحيز، قالت الشركة إنها تعمل على تحسين تقنية الذكاء الاصطناعي التوليدية، لكنها لم تقدم الكثير من التفاصيل حول العملية.

“هذه تقنية جديدة ولا تعطي دائمًا الإجابة المطلوبة، وهو نفس الشيء بالنسبة لجميع أنظمة الذكاء الاصطناعي التوليدية. وقال متحدث باسم الشركة في بيان: “منذ إطلاقنا، أصدرنا باستمرار تحديثات وتحسينات لنماذجنا ونواصل العمل على تحسينها”.

ميتا آي آي أكبر ميزة هي أنه مجاني ومتاح بسهولة على عدة أسطح. ولذلك فإن الملايين من الناس من ثقافات مختلفة سوف يستخدمونها بطرق مختلفة. في حين أن شركات مثل Meta تعمل دائمًا على تحسين نماذج توليد الصور من حيث الدقة في كيفية إنشاء الأشياء والبشر، فمن المهم أيضًا أن تعمل على هذه الأدوات لمنعها من اللعب على الصور النمطية.

من المحتمل أن ترغب Meta في أن يستخدم المبدعون والمستخدمون هذه الأداة لنشر المحتوى على منصاتها. ومع ذلك، إذا استمرت التحيزات التوليدية، فإنها تساهم أيضًا في تأكيد التحيزات أو تفاقمها بين المستخدمين والمشاهدين. الهند بلد متنوع به العديد من تقاطعات الثقافة والطبقة والدين والمنطقة واللغات. ستحتاج الشركات التي تعمل على أدوات الذكاء الاصطناعي إلى ذلك أفضل في تمثيل أشخاص مختلفين.

إذا وجدت أي نماذج ذكاء اصطناعي تولد نتائج غير عادية أو متحيزة، فيمكنك الاتصال بي على im@ivanmehta.com عبر البريد الإلكتروني ومن خلال هذا الرابط على Signal.

Source link